谷歌开源 3D 舞蹈生成模型 FACT,

谷歌开源 3D 舞蹈生成模型 FACT,

谷歌开源了其基于 AIST++ 的 3D 舞蹈生成模型 FACT。该模型不仅可以学习音乐-运动对应关系,还可以生成以音乐为基础的 3D 运动序列。

此前,谷歌层发布了大规模的多模态 3D 舞蹈动作数据集 AIST++,它包含了 1408 个序列中 5.2 小时的 3D 舞蹈动作,涵盖了 10 种舞蹈流派,每个序列都包括已知相机姿势的多视角视频。而 FACT 模型则可以使用使用这些数据从音乐生成 3D 舞蹈,甚至可以帮助增强一个人的编舞能力。

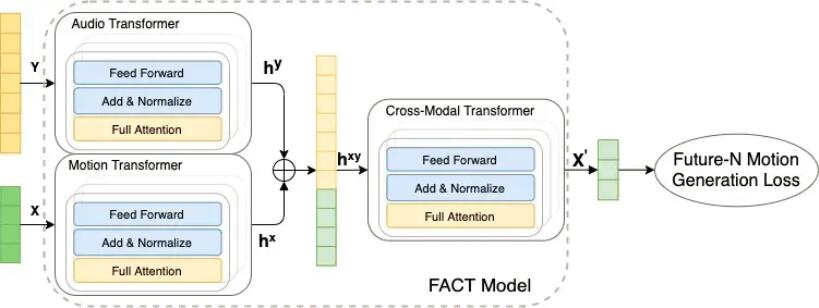

根据谷歌描述,该模型首先使用单独的运动和音频转换器对种子运动和音频输入进行编码,然后将嵌入连接起来并发送到跨模态转换器,该转换器学习两种模态之间的对应关系并生成 N 个未来的运动序列,然后使用这些序列以自我监督的方式训练模型。在测试时,将此模型应用于自回归框架,其中预测的运动作为下一代步骤的输入,从而使 FACT 模型能够逐帧生成长距离舞蹈动作。

此外,谷歌还解释了 FACT 涉及的三个关键设计选择,这些选择对于从音乐中产生逼真的 3D 舞蹈动作至关重要,包括所有转换器都使用全注意掩码、训练模型会预测当前输入之外的 N 个未来而不仅仅是下一个动作以及采用了一个深度的12层跨模式转换模块。最终,FACT 表现出了较好的运动质量、生成多样性、以及节拍对齐分数。

目前,用于训练的数据 AIST++、FACT 模型代码以及一个经过训练的模型均已发布。

本文转自OSCHINA

本文标题:谷歌开源 3D 舞蹈生成模型 FACT

本文地址:https://www.oschina.net/news/160132/google-publish-fact

评论暂时关闭