hadoop文件损坏解决办法,

hadoop文件损坏解决办法,

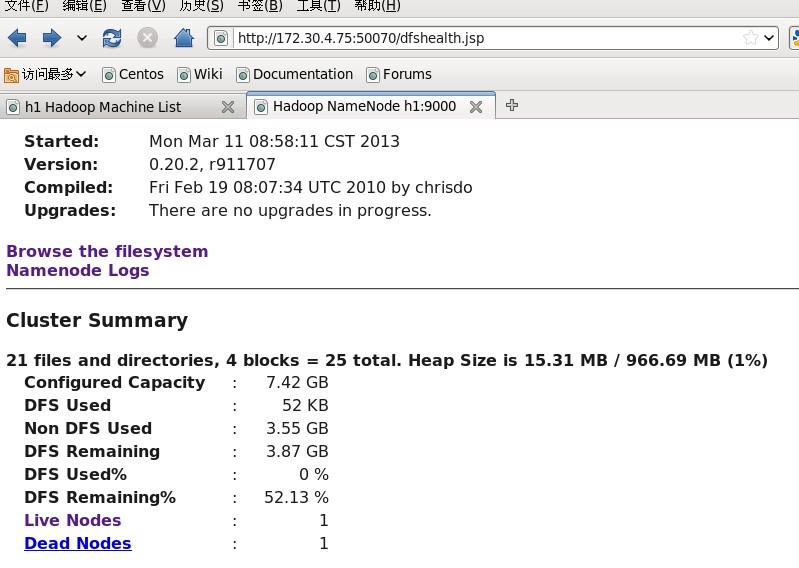

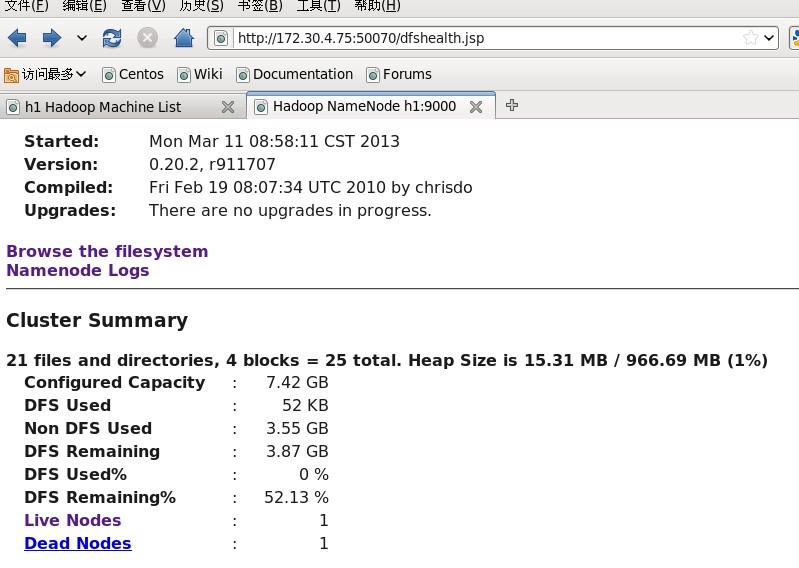

今天把集群重新扩容了一下,把之前的两台电脑重新装了系统,结果启动hadoop发现报错了

问题原因:在hdfs-site中配置的副本书为1,而且把两台机子的文件给清理了,导致一部分数据丢失,而且无法恢复,报错导致hbase无法访问60010端口

解决办法:使用 hadoop fsck / 列出损坏文件,损坏的文件无法恢复,只能删除损坏的文件 hadoop fsck -delete

今天把集群重新扩容了一下,把之前的两台电脑重新装了系统,结果启动hadoop发现报错了

问题原因:在hdfs-site中配置的副本书为1,而且把两台机子的文件给清理了,导致一部分数据丢失,而且无法恢复,报错导致hbase无法访问60010端口

解决办法:使用 hadoop fsck / 列出损坏文件,损坏的文件无法恢复,只能删除损坏的文件 hadoop fsck -delete

评论暂时关闭