10G以太网:不只是一个更大的管道(1)(8)

三个参与测试的网卡在传输巨型帧时的表现都很糟糕,巨型帧将每块网卡的CPU负载从13-14%降低到了10%,但速度仅有5-5.6Gbit/s,让人相当失望。Solarflare和Neterion网卡显然是为虚拟化环境制造的,我们使用标准以太网帧测试时,Neterion和英特尔网卡的的CPU负载保持在14%左右,而Solarflare网卡需要10%左右的CPU负载,当我们开启巨型帧后,所有网卡都需要大约10%的CPU负载至强E5504 2GHz)。

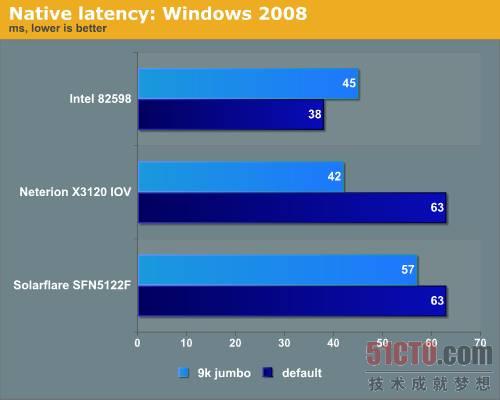

图 13 在Windows Server 2008上进行延迟测试的结果

Solarflare网卡的延迟比其它的要高,因为Solarflare为Linux开源网络堆栈OpenOnload做了许多工作,我们猜测Solarflare声称的低延迟是Linux下的网卡延迟,因为在HPC集群世界Linux占据主导地位,延迟比带宽更重要,因此Solarflare的做法很有意义。

ESX 4.0性能

让我们看看这些网卡在虚拟环境中能做什么,在ESX 4.1中做了一些测试后,我们返回到ESX 4.0u2,因为有大量的驱动问题,这肯定不是网卡厂商一家的责任,显然,VMDirectPath在ESX 4.1中遭到了破坏,幸运的是,已经有人提交了BUG报告,相信在update 1中这个问题会得到解决。

我们从Windows Server 2008节点开始测试NTttcp。

NTttcp -m 4,0, [ip number] -a 4 -t 120

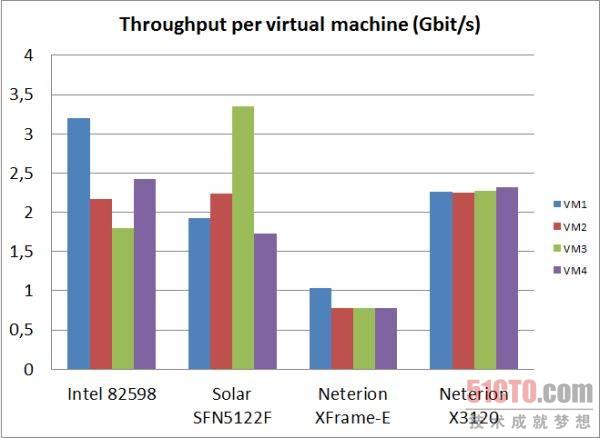

在虚拟节点上,我们使用Windows 2008创建了4个VM,每个VM开启4个网络负载线程,换句话说就是,总共会有16个活动线程,它们发送的数据包全部都要经过一个网卡端口。

图 14 单虚拟机吞吐量测试

评论暂时关闭